أحد هواجس شركة آبل هو أمن من مستخدميها. نعلم جميعًا مدى اهتمام الشركة بخصوصية عملائها ، وهو شيء مقدس لشركة Apple. حتى لو كان عليه مواجهة حكومة الولايات المتحدة ، حتى وكالة المخابرات المركزية. شعارهم "لم يتم لمس بيانات المستخدمين".

والآن ركزت على سلامة مستخدميها دون السن القانونية. سوف تصنع "الاخ الاكبر»مراقبة الصور التي تمر عبر خوادمها ، سواء عند إرسال الرسائل والصور المحفوظة في iCloud ، للكشف عن الصور التي تحتوي على مواد اعتداء جنسي على الأطفال. أحسنت.

أعلن هؤلاء من كوبرتينو هذا الأسبوع للتو عن سلسلة من الإجراءات التي سيقومون بتنفيذها بهدف حماية المستخدمين القصر اي فون, باد y ماك. هذه هي ميزات أمان الاتصال الجديدة في الرسائل ، وتحسين الكشف عن محتوى مواد الاعتداء الجنسي على الأطفال (CSAM) في iCloud ، ومعلومات معرفية محدثة لـ Siri والبحث.

يعني ما رأيك افحص كل صورة من المستخدمين الذين تقل أعمارهم عن 13 عامًا والذين يمرون عبر خوادمها ، إما في إرسال أو استقبال الرسائل ، أو تلك المخزنة في iCloud ، لاكتشاف أولئك المشتبه بهم في محتوى إباحي للأطفال. بمجرد تحديد موقع الصورة المشبوهة تلقائيًا ، سيتم الإبلاغ عن قيام شخص بالتحقق منها. سيكون هناك أيضًا ضوابط على عمليات البحث وسيري.

الصور المرفقة بالرسائل

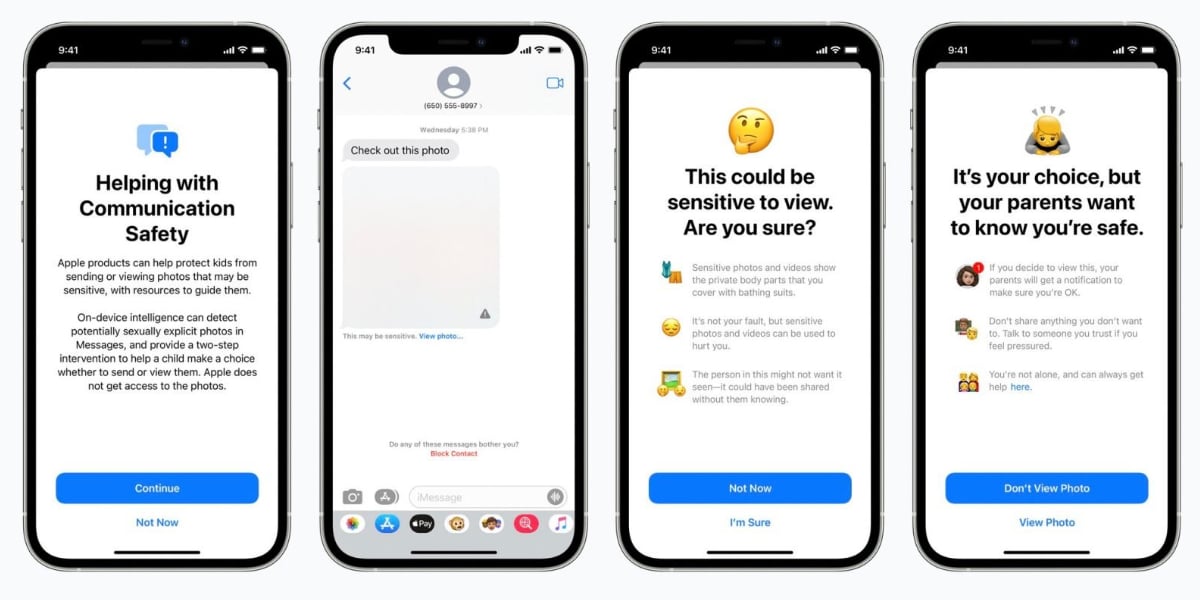

توضح Apple أنه عندما يكون القاصر في عائلة iCloud يتلقى أو يحاول إرسال رسالة بها صور ذات محتوى جنسي ، سيرى الطفل رسالة تحذير. سيتم تعتيم الصورة وسيعرض تطبيق الرسائل تحذيرًا يفيد بأن الصورة "قد تكون حساسة". إذا لمس الطفل "عرض الصورة" ، سيرى رسالة منبثقة تخبره عن سبب اعتبار الصورة حساسة.

إذا أصر القاصر على رؤية الصورة ، فسيحصل والديه من iCloud Family على ملف إعلام "للتأكد من صحة المشاهدة." ستتضمن النافذة المنبثقة أيضًا ارتباطًا سريعًا للحصول على مساعدة إضافية.

في حالة محاولة الطفل إرسال صورة توصف بأنها جنسية ، فسوف يرى تحذيرًا مشابهًا. تقول Apple إنه سيتم تحذير القاصر قبل إرسال الصورة وأنه يمكن للوالدين تلقي رسالة إذا قرر الطفل إرسالها. سيتم تنفيذ هذا التحكم في حسابات معرف Apple التي تنتمي إلى الأطفال تحت 13 سنوات.

صور iCloud

هذه هي الطريقة التي ستعالج بها Apple صور طفل أقل من 13 عامًا.

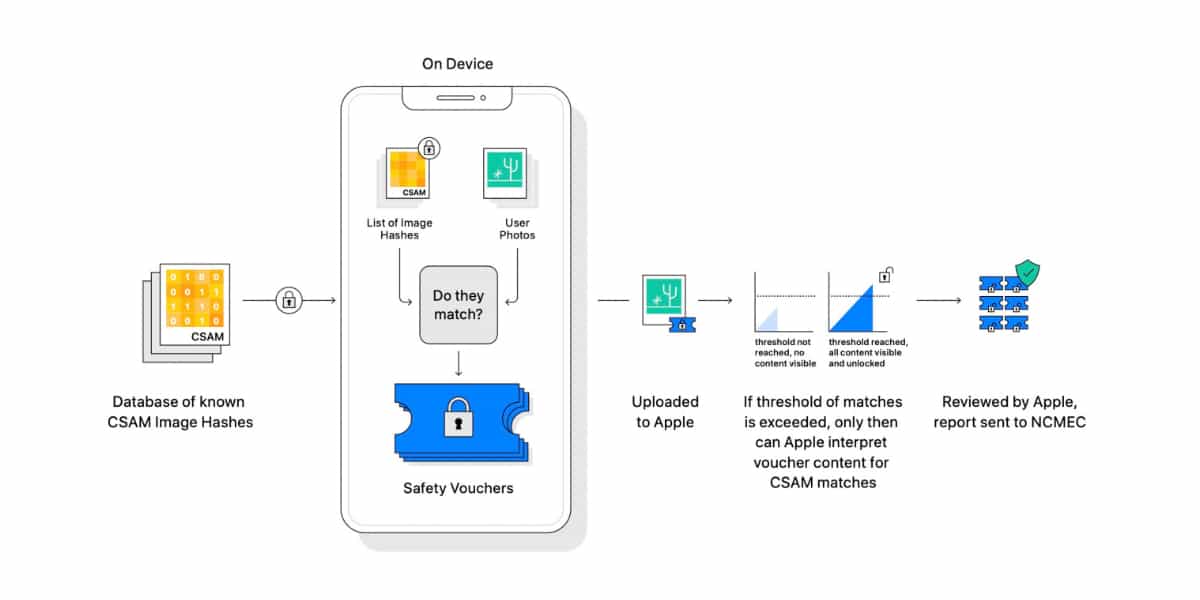

أبل تريد كشف صور CSAM (مواد الاعتداء الجنسي على الأطفال) عند تخزينها في صور iCloud. ستكون الشركة بعد ذلك قادرة على إبلاغ المركز الوطني للأطفال المفقودين والمستغلين ، وهو كيان في أمريكا الشمالية يعمل بمثابة وكالة إبلاغ شاملة لـ CSAM ويعمل بشكل وثيق مع تطبيق القانون.

إذا عثر النظام على صورة CSAM محتملة ، فيبلغ عنها تم التحقق من قبل شخص حقيقي، قبل اتخاذ أي إجراء. بمجرد التأكيد ، ستقوم Apple بتعطيل حساب المستخدم وإرسال تقرير إلى المركز الوطني الأمريكي للأطفال المفقودين والمستغلين.

من الواضح أن الصور التي يتم حفظها على الجهاز ولا تمر عبر خوادم iCloud لا يمكن التحكم فيها بواسطة Apple. كل هذا نظام مراقبة الطفل سيتم تنفيذه أولاً في الولايات المتحدة. ، وبعد ذلك سيتم توسيعه ليشمل بقية البلدان ، بدءًا من iOS 15 و iPadOS 15 و macOS Monterey.

عمليات البحث وسيري

سيكون Siri على دراية بعمليات البحث التي يمكن للمستخدم إجراؤها فيما يتعلق بـ موضوع CSAM. على سبيل المثال ، سيتم توجيه أولئك الذين يسألون Siri عن كيفية الإبلاغ عن CSAM أو استغلال الأطفال إلى الموارد المتعلقة بمكان وكيفية تقديم التقرير ، وبالتالي تسهيل الملاحقة القضائية المحتملة.

شخصيات مثل جون كلارك، الرئيس والمدير التنفيذي للمركز الوطني للأطفال المفقودين والمستغلين ، ستيفن بلكام، المؤسس والرئيس التنفيذي لمعهد Family Online Safety Institute ، المدعي العام السابق اريك هولدر أو النائب العام السابق جورج Terwilliger لقد أعربوا عن دعمهم الكامل لمبادرة أبل.