This video shows an AirPower prototype charging an Apple Watch Series 4

One of the most important soap operas in Apple's recent history was Apple's multi-device charging base...

One of the most important soap operas in Apple's recent history was Apple's multi-device charging base...

Progress in the development of new functions for messaging applications continues to be a challenge for…

The first alternative iPhone app store is here. European regulations have forced Apple to accept…

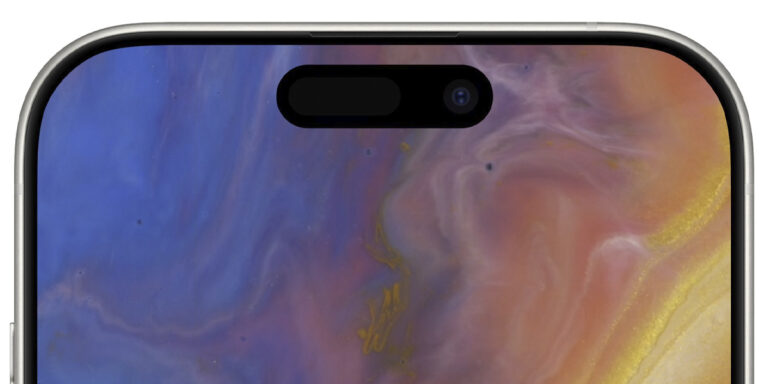

Apple took a step forward last year with the launch of the iPhone 15 Pro Max, eliminating the option…

Apple continues the development of iOS 17.5, the next update for iPhone and iPad, in addition to updates for…

We analyze the reMarkable 2 electronic notebook, the closest thing to writing on paper that we have ever tried, with all…

Apple is alerting some users of mercenary Spyware that has been identified and could be attacking iPhones. The possible…

A serious problem affects some Apple Watch Ultra 2, and at the moment Apple only offers a temporary solution. Now…

The month of June is just around the corner and everyone is paying attention to what…

We tested the new Lululook sports straps, made with fluoroelastomer, comfortable and perfect for practicing sports with any model of…

The month of June is approaching and with it WWDC24, one of the most important events for Apple in…