หนึ่งในความหลงใหลของ Apple คือ ความปลอดภัย ของผู้ใช้ เราทุกคนทราบดีว่าบริษัทให้ความสำคัญกับความเป็นส่วนตัวของลูกค้ามากเพียงใด ซึ่งเป็นสิ่งศักดิ์สิทธิ์สำหรับ Apple การทำเช่นนี้เขาต้องเผชิญหน้ากับรัฐบาลสหรัฐ แม้แต่ซีไอเอ "ข้อมูลผู้ใช้ของฉันไม่ถูกแตะต้อง" คือคำขวัญของพวกเขา

และตอนนี้ได้มุ่งเน้นไปที่ความปลอดภัยของผู้ใช้ที่ยังไม่บรรลุนิติภาวะ มันจะทำ «พี่ชาย»การตรวจสอบภาพที่ส่งผ่านเซิร์ฟเวอร์ ทั้งเมื่อส่งข้อความและรูปภาพที่จัดเก็บไว้ใน iCloud เพื่อตรวจจับรูปภาพที่มีเนื้อหาเกี่ยวกับการล่วงละเมิดทางเพศเด็ก ไชโย

ผู้มาจากคูเปอร์ติโนเพิ่งประกาศในสัปดาห์นี้ถึงชุดของมาตรการที่พวกเขาจะดำเนินการโดยมีวัตถุประสงค์เพื่อปกป้องผู้ใช้ที่ยังไม่บรรลุนิติภาวะของ iPhone, iPad y Mac. ซึ่งรวมถึงคุณสมบัติด้านความปลอดภัยในการสื่อสารใหม่ในข้อความ การตรวจหาเนื้อหาเกี่ยวกับการล่วงละเมิดทางเพศเด็ก (CSAM) ใน iCloud ที่ได้รับการปรับปรุง และข้อมูลความรู้ที่อัปเดตสำหรับ Siri และการค้นหา

หมายความว่าไง คิดอะไรอยู่ ตรวจสอบแต่ละภาพ ของผู้ใช้ที่อายุต่ำกว่า 13 ปีซึ่งผ่านเซิร์ฟเวอร์ของตน ไม่ว่าจะในการปล่อยหรือรับข้อความ หรือที่จัดเก็บไว้ใน iCloud เพื่อตรวจจับผู้ที่ต้องสงสัยเนื้อหาลามกอนาจารของเด็ก เมื่อพบภาพที่น่าสงสัยโดยอัตโนมัติแล้ว ภาพนั้นจะถูกรายงานให้ตรวจสอบโดยบุคคล นอกจากนี้ยังมีการควบคุมการค้นหาและ Siri

รูปภาพที่แนบมากับข้อความ

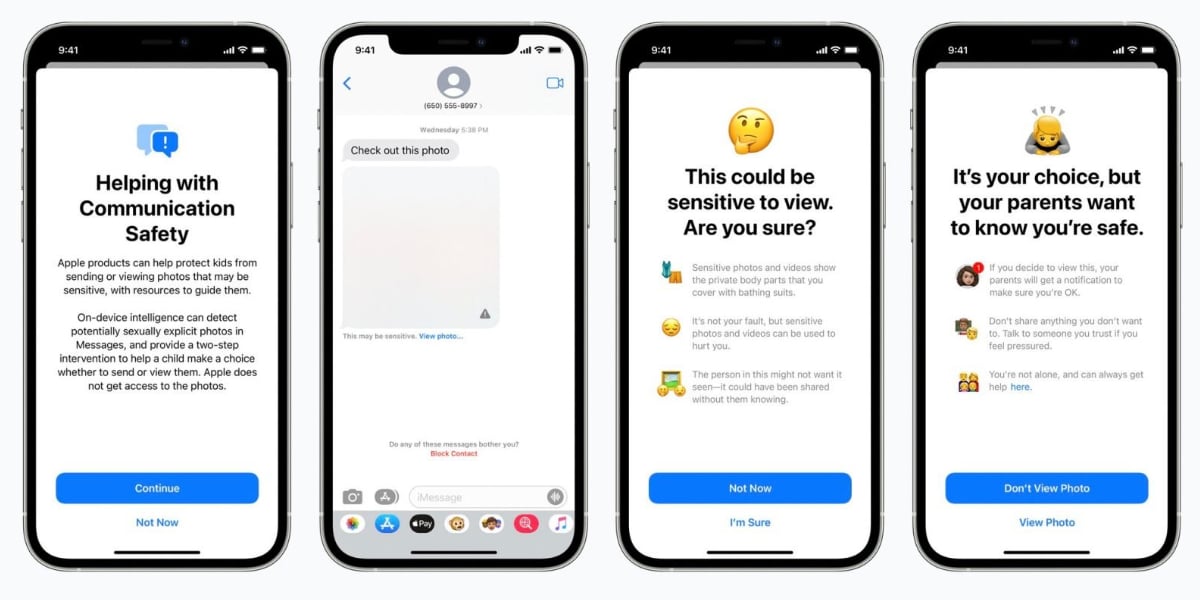

Apple อธิบายว่าเมื่อผู้เยาว์ที่อยู่ในa ครอบครัวไอคลาวด์ รับหรือพยายามส่งข้อความพร้อมรูปภาพที่มีเนื้อหาเกี่ยวกับเรื่องเพศ เด็กจะเห็นข้อความเตือน รูปภาพจะเบลอและแอพ Messages จะแสดงคำเตือนว่ารูปภาพนั้น "อาจมีความละเอียดอ่อน" หากเด็กแตะ "ดูรูปภาพ" พวกเขาจะเห็นข้อความป๊อปอัปแจ้งว่าเหตุใดรูปภาพจึงถือว่าละเอียดอ่อน

หากผู้เยาว์ยืนยันที่จะดูภาพ พ่อของเขาจากตระกูล iCloud จะได้รับ a การแจ้งเตือน "เพื่อให้แน่ใจว่าการดูถูกต้อง" หน้าต่างป๊อปอัปจะมีลิงก์ด่วนสำหรับความช่วยเหลือเพิ่มเติม

ในกรณีที่เด็กพยายามส่งภาพที่อธิบายว่าเป็นเรื่องทางเพศ พวกเขาจะเห็นคำเตือนที่คล้ายกัน Apple กล่าวว่าผู้เยาว์จะได้รับคำเตือนก่อนที่จะส่งรูปถ่ายและผู้ปกครองสามารถรับข้อความได้หากเด็กตัดสินใจส่ง การควบคุมนี้จะดำเนินการในบัญชี Apple ID ที่เป็นของ เด็กอายุต่ำกว่า 13 ปี.

รูปภาพใน iCloud

นี่คือวิธีที่ Apple ประมวลผลภาพถ่ายของเด็กอายุต่ำกว่า 13 ปี

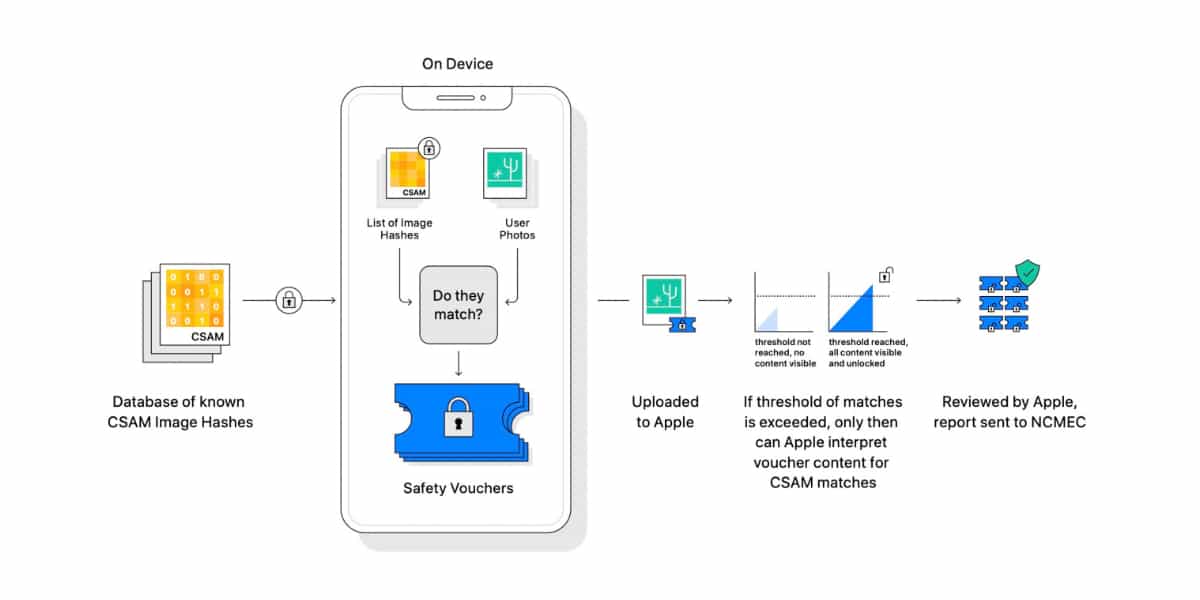

แอปเปิ้ลต้องการ ตรวจจับภาพ CSAM (สื่อการล่วงละเมิดทางเพศเด็ก) เมื่อจัดเก็บไว้ในรูปภาพ iCloud จากนั้นบริษัทจะสามารถรายงานเคล็ดลับไปยัง National Center for Missing and Exploited Children ซึ่งเป็นหน่วยงานในอเมริกาเหนือที่ทำหน้าที่เป็นหน่วยงานการรายงานที่ครอบคลุมสำหรับ CSAM และทำงานอย่างใกล้ชิดกับการบังคับใช้กฎหมาย

หากระบบพบอิมเมจ CSAM ที่เป็นไปได้ ระบบจะรายงานเป็น ตรวจสอบโดยบุคคลจริงก่อนดำเนินการใดๆ เมื่อได้รับการยืนยันแล้ว Apple จะปิดการใช้งานบัญชีผู้ใช้และส่งรายงานไปยัง US National Center for Missing & Exploited Children

รูปภาพที่บันทึกไว้ในอุปกรณ์และไม่ผ่านเซิร์ฟเวอร์ iCloud เห็นได้ชัดว่า Apple ไม่สามารถควบคุมได้ ระบบควบคุมเด็กทั้งหมดนี้ มันจะถูกนำไปใช้ในสหรัฐอเมริกาครั้งแรก. และหลังจากนั้นจะขยายไปยังประเทศอื่นๆ โดยเริ่มตั้งแต่ iOS 15, iPadOS 15 และ macOS Monterey

การค้นหาและ Siri

Siri จะรับรู้ถึงการค้นหาที่ผู้ใช้สามารถทำเกี่ยวกับ ธีม CSAM. ตัวอย่างเช่น ผู้ที่ถาม Siri ว่าสามารถรายงาน CSAM หรือการแสวงประโยชน์จากเด็กได้อย่างไร จะถูกนำไปยังแหล่งข้อมูลว่าจะส่งรายงานที่ไหนและอย่างไร ซึ่งจะทำให้การดำเนินคดีเป็นไปได้ง่ายขึ้น

บุคลิกชอบ จอห์นคลาร์ก, ประธานและประธานเจ้าหน้าที่บริหารศูนย์เด็กหายและเด็กหลงทางแห่งชาติ สตีเฟน บัลคัมผู้ก่อตั้งและ CEO ของ Family Online Safety Institute อดีตอัยการสูงสุด Eric Holder หรืออดีตรองอัยการสูงสุด จอร์จ เทอร์วิลลิเกอร์ พวกเขาได้แสดงการสนับสนุนอย่างเต็มที่สำหรับความคิดริเริ่มของ Apple