看来苹果已经决定停止其 CSAM计划 它计划对其用户寻找儿童色情内容的照片实施的修订。 苹果网站上再也没有这个有争议的计划的踪迹。

我们不知道目前是暂时退出,寻找实施该系统的最佳方式,还是只是中止项目。 事实是 CSAM 计划已经从儿童安全页面上消失了。 网络公报 Apple的。

几个月来,我们一直在谈论 Apple 考虑的有争议的项目,以提高其设备数字内容的安全性。 它被称为 CSAM计划 Apple的。

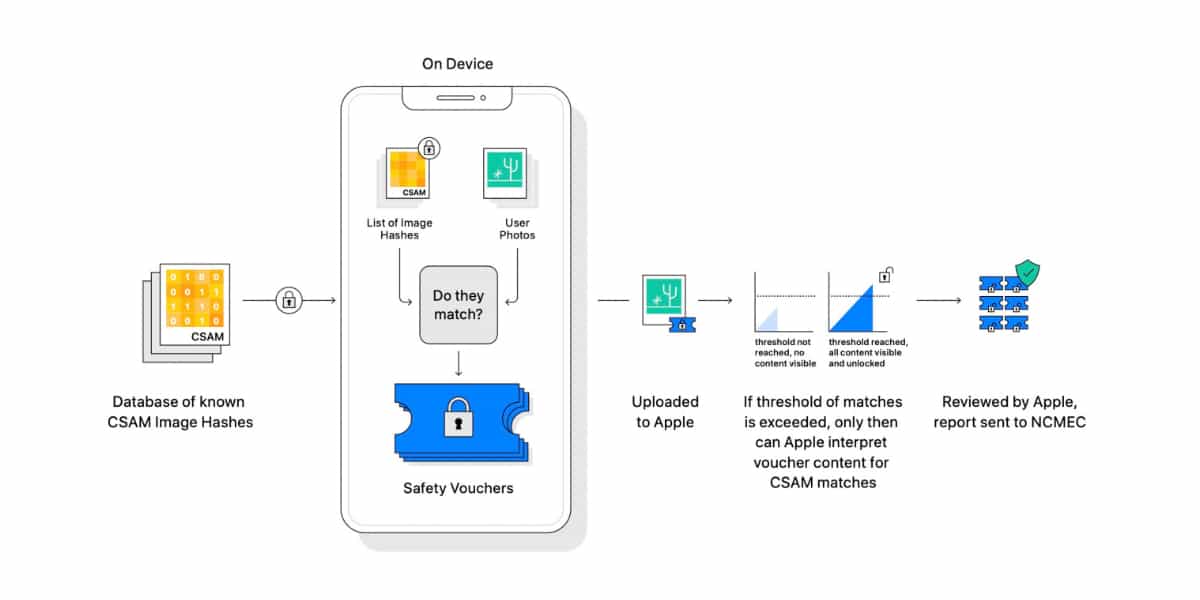

这个计划想要使用一个组合的先自动后手动系统,称为 神经匹配 在用户的私人照片库中发现可疑的虐待儿童图像,这些照片将它们保存在 iCloud 中。

该系统旨在对用户保存在其 iCloud 帐户中的所有照片进行自动数字扫描。 如果服务器软件检测到可能包含儿童色情内容的“可疑”照片,它会提醒一组 人工审核员 供他们检查。

如果上述评论者发现图片中可能存在虐待儿童的情况,Apple 我会把它传达给地方当局 相关的。 公司的意图显然是好的,但公司的 隐私 的人。

在 Apple 宣布其 CSAM 计划后不久,它就面临来自隐私团体、权利团体和隐私组织的一连串批评。 隐私权. 甚至一些公司员工也加入了对他们公司项目的负面反应。

项目停止,未丢弃

现在苹果 已抹去 从您的页面 儿童安全 从其官方网站上可以看出计划在未来版本中启动的 CSAM 项目的任何迹象 iOS的15. 根据刚刚公布的 一触即发Apple 并没有放弃 CSAM 项目,而是想看看它如何修改它以便所有那些反对者都接受它。 难有。