Het lijkt erop dat Apple heeft besloten ermee te stoppen CSAM-plan van de herzieningen die het van plan was uit te voeren van de foto's van zijn gebruikers die op zoek waren naar kinderpornografie. Op de website van Apple is geen spoor meer te bekennen van het omstreden plan.

We weten op dit moment niet of het een tijdelijke terugtrekking is, zoeken naar de beste manier om het systeem te implementeren, of gewoon het project afbreken. Feit is dat het CSAM-plan is verdwenen van de kinderveiligheidspagina van de web oficial van Apple.

We praten nu al enkele maanden over het controversiële project dat Apple in gedachten had, om de veiligheid van de digitale inhoud van zijn apparaten te vergroten. Het is de zgn CSAM-plan van Apple.

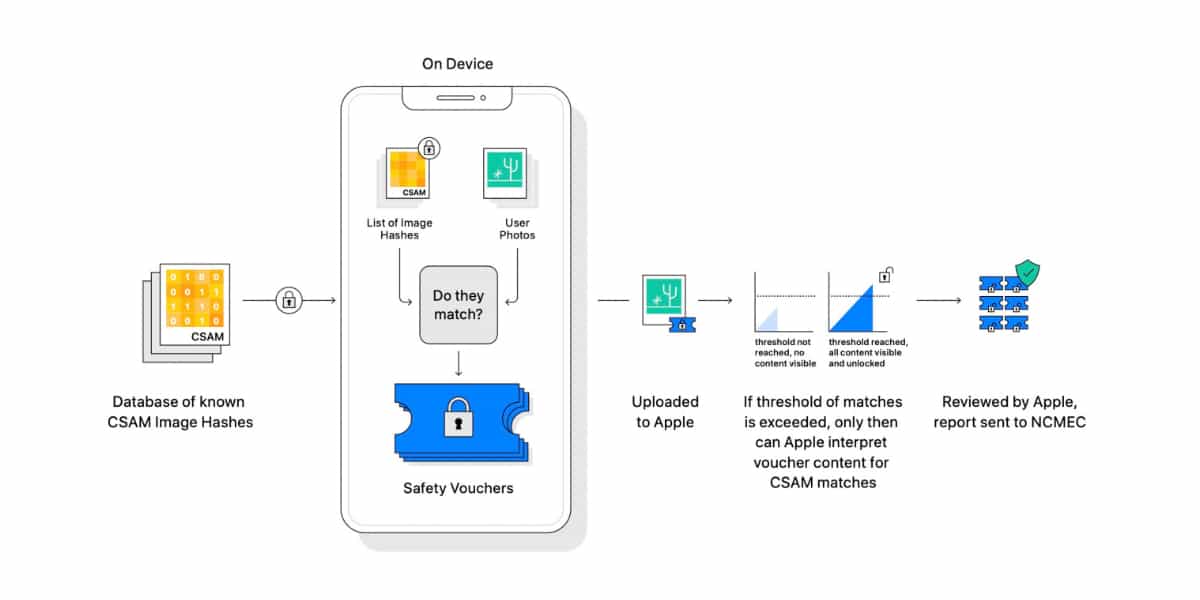

Dit plan wilde gebruik maken van een gecombineerd eerst automatisch en daarna handmatig systeem genaamd neuralMatch om afbeeldingen te ontdekken die verdacht worden van kindermisbruik in de privéfotobibliotheken van gebruikers die ze in iCloud bewaren.

Het systeem was bedoeld om een automatische digitale scan uit te voeren van alle foto's die een gebruiker op zijn iCloud-account opslaat. Als de serversoftware een mogelijke foto detecteerde die "verdacht" was van kinderpornografie, waarschuwde het een team van menselijke recensenten voor hen om te controleren.

Als die recensent mogelijk kindermisbruik in het beeld zag, zou Apple Ik zou de lokale autoriteiten op de hoogte stellen relevant. De bedoelingen van het bedrijf waren uiteraard goed, maar de privacy van de mensen.

Kort nadat Apple zijn CSAM-plan had aangekondigd, kreeg het te maken met een spervuur van kritiek van privacygroepen, rechtengroepen en privacyorganisaties. Recht op privacy. Zelfs sommige groepen werknemers van het bedrijf sloten zich aan bij de negatieve reactie op het project van hun bedrijf.

Project gestopt, niet weggegooid

Appel Nu heeft gewist vanaf uw pagina Kinder veiligheid vanaf zijn officiële website elke indicatie van het CSAM-project, gepland om te worden gelanceerd in een toekomstige versie van iOS 15. Zoals zojuist gepubliceerd The Verge, Apple heeft het CSAM-project niet opgegeven, maar wil kijken hoe het kan worden aangepast zodat het door al die tegenstanders wordt geaccepteerd. Het is lastig.