Apple 的痴迷之一是 安全 它的用户。 我们都知道该公司非常关心客户的隐私,这对苹果来说是神圣的。 尽管为此他必须面对美国政府,甚至中央情报局。 “我的用户的数据没有被触及”是他们的座右铭。

现在它专注于未成年用户的安全。 它会做«大哥»在发送消息和存储在 iCloud 中的照片时监控通过其服务器的图像,以检测包含儿童性虐待材料的照片。 太棒了。

库比蒂诺的那些人本周刚刚宣布了他们将实施的一系列措施,目的是保护未成年用户 iPhone, iPad的 y Mac. 其中包括信息中的新通信安全功能、改进了对 iCloud 中儿童性虐待材料 (CSAM) 内容的检测,以及更新了 Siri 和搜索的知识信息。

我的意思是,你怎么看 检查每张照片 13 岁以下的用户通过其服务器发送或接收信息,或存储在 iCloud 中的信息,以检测可疑儿童色情内容的用户。 一旦可疑图像被自动定位,就会报告由一个人进行验证。 搜索和 Siri 也将受到控制。

附加到消息的照片

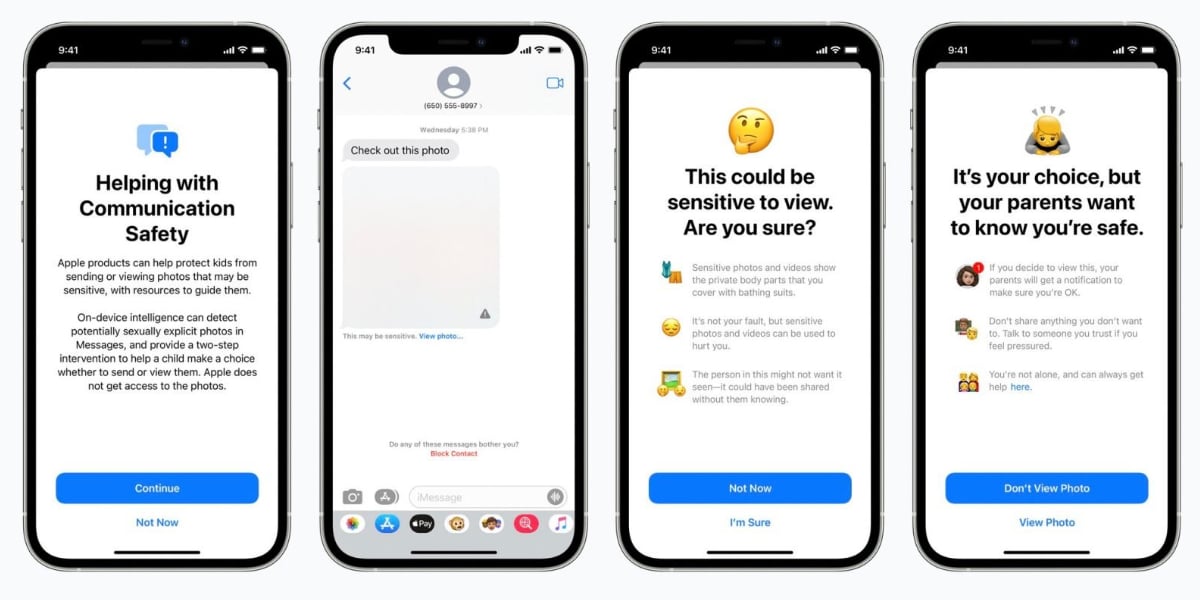

Apple 解释说,当未成年人处于 iCloud 家族 收到或尝试发送带有色情内容照片的消息,孩子将看到警告消息。 图像将变得模糊,消息应用程序将显示警告,指出图像“可能敏感”。 如果孩子触摸“查看照片”,他们将看到一条弹出消息,告知他们为什么该图像被认为是敏感的。

如果孩子坚持查看照片,他们的 iCloud 家庭父亲将收到 通知 “为了确保观看是正确的。” 弹出窗口还将包含一个用于其他帮助的快速链接。

如果孩子试图发送被描述为色情的图片,他们会看到类似的警告。 苹果公司表示,在发送照片之前会警告未成年人,如果孩子决定发送,父母可以收到一条消息。 此控制将在属于的 Apple ID 帐户中进行 13岁以下的儿童.

iCloud中的照片

这就是 Apple 处理 13 岁以下儿童照片的方式。

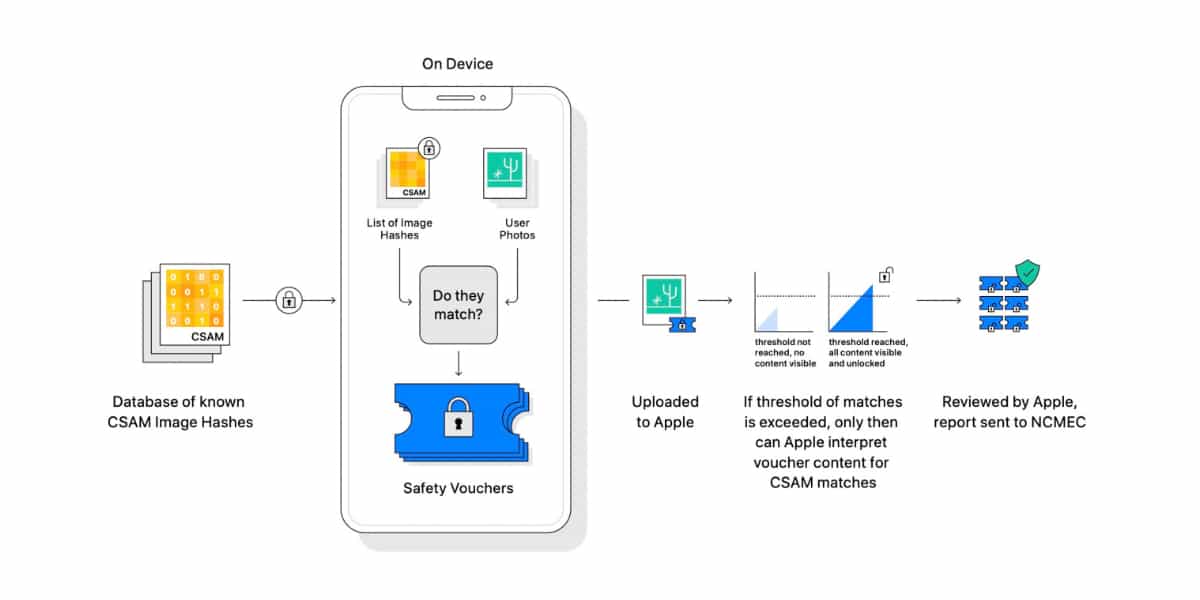

苹果想要 检测 CSAM 图像 (儿童性虐待材料)存储在 iCloud 照片中。 然后,该公司将能够向国家失踪和受虐儿童中心报告线索,该中心是一个北美实体,作为 CSAM 的综合报告机构,并与执法部门密切合作。

如果系统找到一个可能的 CSAM 图像,它会报告它是 由真人验证,在采取任何行动之前。 一旦确认,Apple 将禁用该用户的帐户并向美国国家失踪与受虐儿童中心提交报告。

保存在设备上且不通过iCloud服务器的图像,显然无法被Apple控制。 这个完整的儿童控制系统 它将首先在美国实施.,后来会扩展到其他国家,从 iOS 15、iPadOS 15 和 macOS Monterey 开始。

搜索和 Siri

Siri 会知道用户可以进行的关于 CSAM 主题. 例如,那些询问 Siri 他们如何报告 CSAM 或儿童剥削的人将被引导到有关在哪里以及如何提交报告的资源,从而促进可能的起诉。

个性喜欢 约翰·克拉克,国家失踪和受虐儿童中心总裁兼首席执行官, 斯蒂芬·巴尔卡姆,家庭在线安全研究所的创始人兼首席执行官,前司法部长 埃里克·霍尔德 或前副检察长 乔治·特威利格 他们表示全力支持苹果的倡议。