看來蘋果已經決定停止其 CSAM計劃 它計劃對其用戶尋找兒童色情內容的照片實施的修訂。 蘋果網站上再也沒有這個有爭議的計劃的踪跡。

我們不知道目前是暫時退出,尋找實施該系統的最佳方式,還是乾脆中止該項目。 事實是 CSAM 計劃已從兒童安全頁面中消失 官方網站 Apple的。

幾個月來,我們一直在談論 Apple 考慮的有爭議的項目,以提高其設備數字內容的安全性。 它被稱為 CSAM計劃 Apple的。

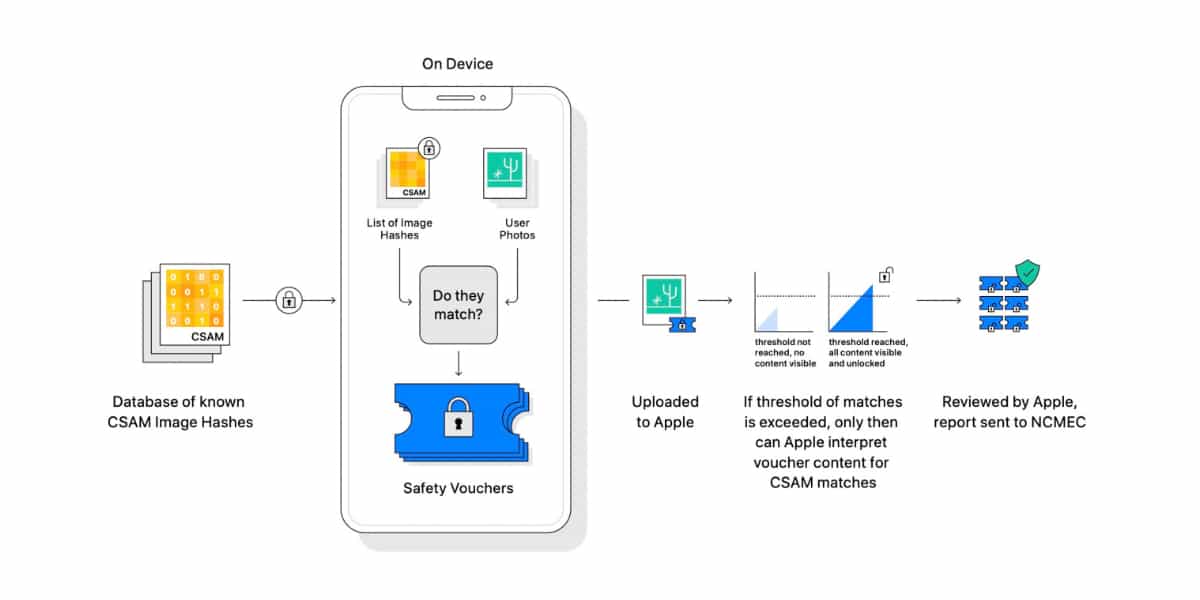

這個計劃想要使用一個組合的先自動後手動系統,稱為 神經匹配 在用戶的私人照片庫中發現可疑的虐待兒童圖像,這些照片將它們保存在 iCloud 中。

該系統旨在對用戶保存在其 iCloud 帳戶中的所有照片進行自動數字掃描。 如果服務器軟件檢測到可能包含兒童色情內容的“可疑”照片,它會提醒一組 人工審核員 供他們檢查。

如果上述評論者發現圖片中可能存在虐待兒童的情況,Apple 我會把它傳達給地方當局 相關的。 公司的意圖顯然是好的,但公司的 隱私 人民。

在 Apple 宣布其 CSAM 計劃後不久,它就面臨來自隱私團體、權利團體和隱私組織的一連串批評。 隱私權. 甚至一些公司員工也加入了對他們公司項目的負面反應。

項目停止,未丟棄

現在蘋果 已抹去 從您的頁面 兒童安全 從其官方網站上可以看出計劃在未來版本中啟動的 CSAM 項目的任何跡象 iOS的15. 根據剛剛公佈的 一觸即發Apple 並沒有放棄 CSAM 項目,而是想看看它如何修改它以便所有那些反對者都接受它。 難有。