Parece ser que Apple ha decidido detener de momento su plan CSAM de las revisiones que tenía previsto implementar de las fotografías de sus usuarios buscando pornografía infantil. Ya no queda ni rastro del controvertido plan en la web de Apple.

No sabemos si de momento es una retirada temporal, buscando la mejor manera de implementar el sistema, o simplemente aborta el proyecto. El caso es que ha desaparecido el plan CSAM de la página de seguridad infantil de la web oficial de Apple.

Llevamos ya algunos meses hablando del polémico proyecto que tenía Apple en mente, para aumentar la seguridad del contenido digital de sus dispositivos. Es el denominado Plan CSAM de Apple.

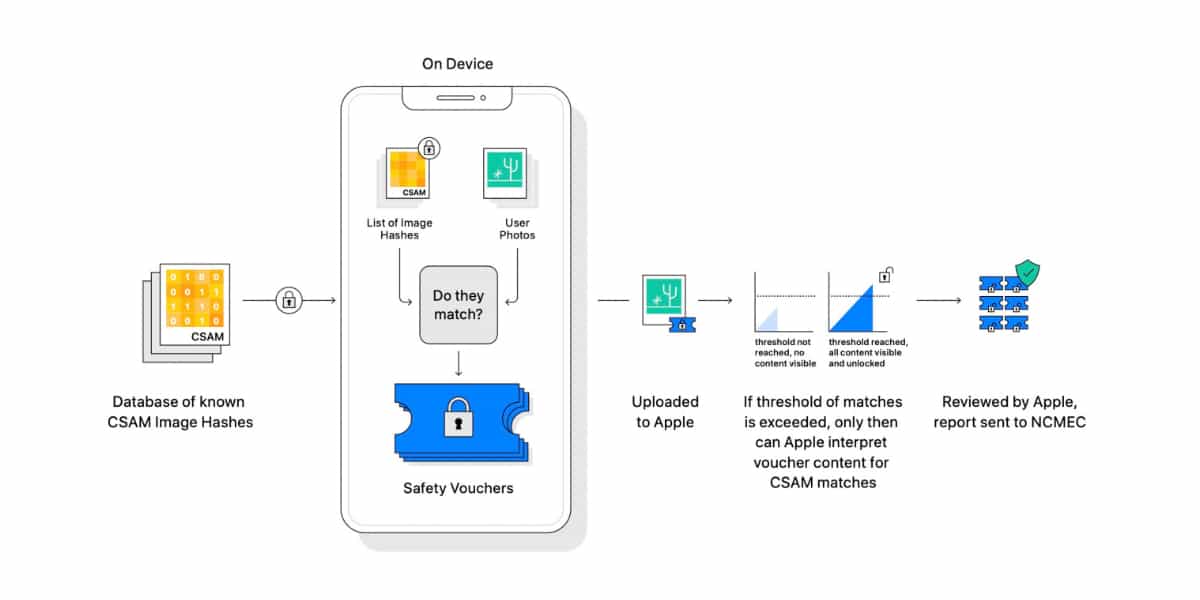

Dicho plan quería usar un sistema combinado primero automático y después manual llamado neuralMatch para descubrir imágenes sospechosas de abuso infantil en las bibliotecas de fotos privadas de los usuarios que las guardan en iCloud.

El sistema pretendía hacer un escaneo digital automático de todas las fotografías que un usuario guarda en su cuenta de iCloud. Si el software de los servidores detectaba una posible fotografía «sospechosa» de contener pornografía infantil, avisaba a un equipo de revisores humanos para que la comprobasen.

Si dicho revisor veía en la imagen un posible abuso infantil, Apple lo comunicaría a las autoridades locales pertinentes. Las intenciones de la compañía eran obviamente buenas, pero quedaba en entredicho la privacidad de las personas.

Poco tiempo después de que Apple anunciara su plan CSAM, se enfrentó a un aluvión de críticas de grupos defensores de la privacidad, grupos de derechos y organizaciones defensoras del derecho a la intimidad. Incluso algunos grupos de empleados de la compañía se unieron a la reacción negativa del proyecto de su empresa.

Proyecto parado, no descartado

Ahora Apple ha borrado de su página de Seguridad Infantil de su web oficial cualquier indicio del proyecto CSAM, previsto para lanzarse en una próxima versión de iOS 15. Según acaba de publicar The Verge, Apple no ha abandonado el proyecto CSAM, sino que quiere ver cómo lo puede modificar para que sea aceptado por todos esos detractores. Difícil lo tiene.